Удаление огромного количества файлов в Linux без завешивания сервера

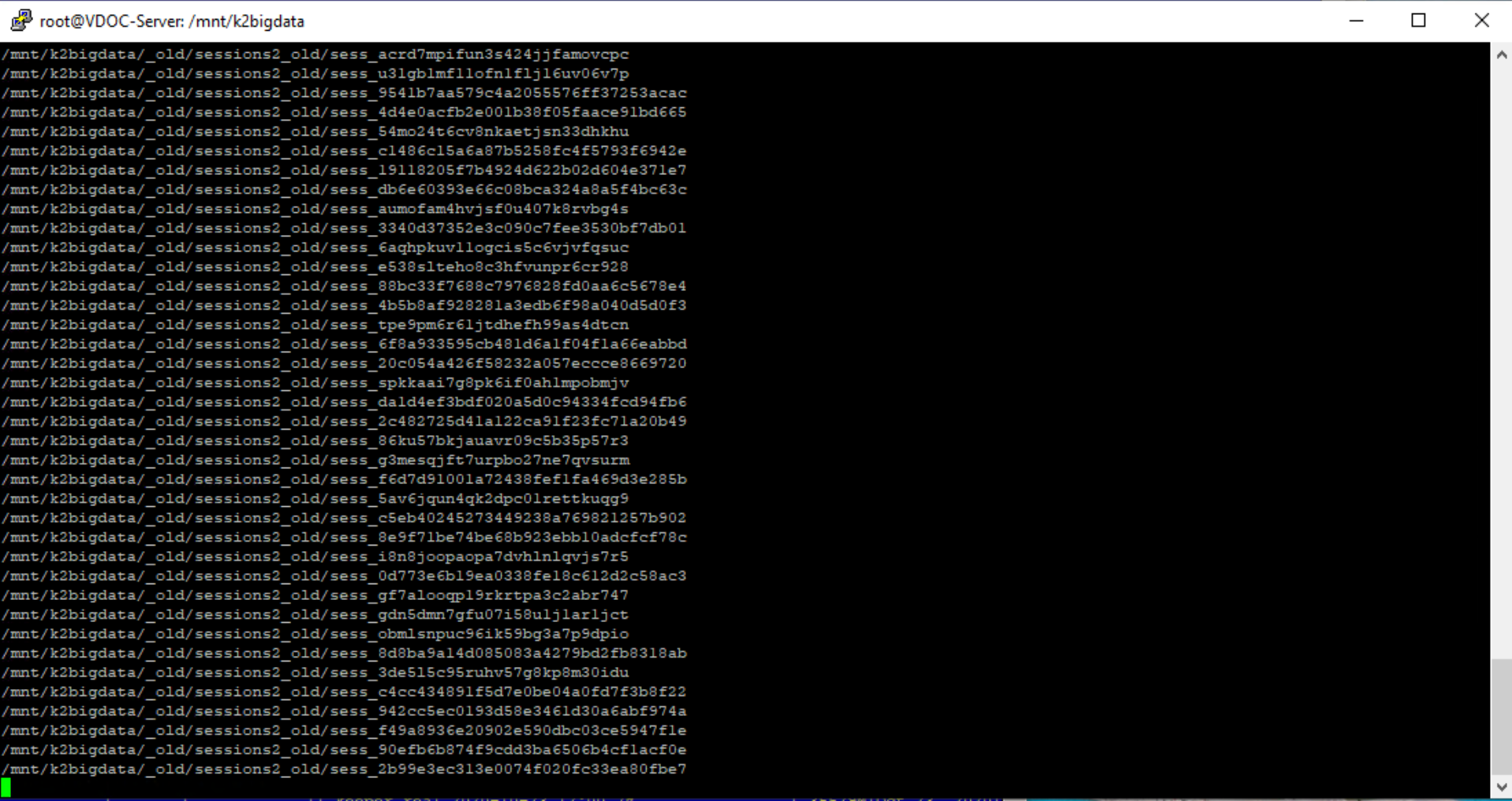

Периодически, каждый администратор сталкивается с проблемой удаления огромного количества мелких файлов. Такие файлы могут генерироваться веб-серверами при создании сессий или другими сервисами. Дело в том, […]